S'abonner à la lettre d'information

Saisissez votre adresse électronique ci-dessous et abonnez-vous à notre lettre d'information

Saisissez votre adresse électronique ci-dessous et abonnez-vous à notre lettre d'information

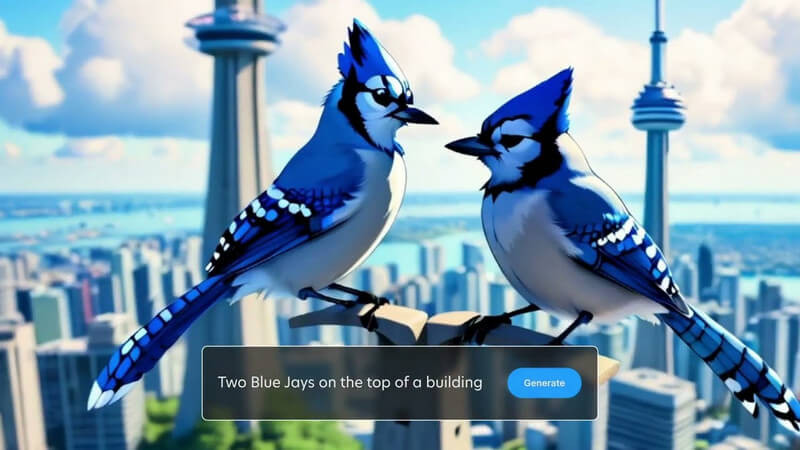

Vous savez peut-être déjà comment créer des images générées par l’IA à l’aide de Stable Diffusion. Désormais, vous pouvez également donner une nouvelle vie à ces images grâce aux graphiques animés générés par l’IA. Bienvenue à Écurie Vidéo La diffusion ce qui peut vous aider à transformer vos images statiques en vidéos dynamiques. Dans cet article, je vais vous faire part de tout ce qui est important concernant le Génération vidéo à diffusion stable et comment l'utiliser comme un pro.

Comme vous le savez, Stable Diffusion est un modèle d'IA open source créé par Stability AI. Avec Stable Diffusion, vous pouvez générer des images en saisissant simplement des invites de texte. Désormais, avec la version vidéo de Stable Diffusion, vous pouvez convertir gratuitement vos images en courtes vidéos.

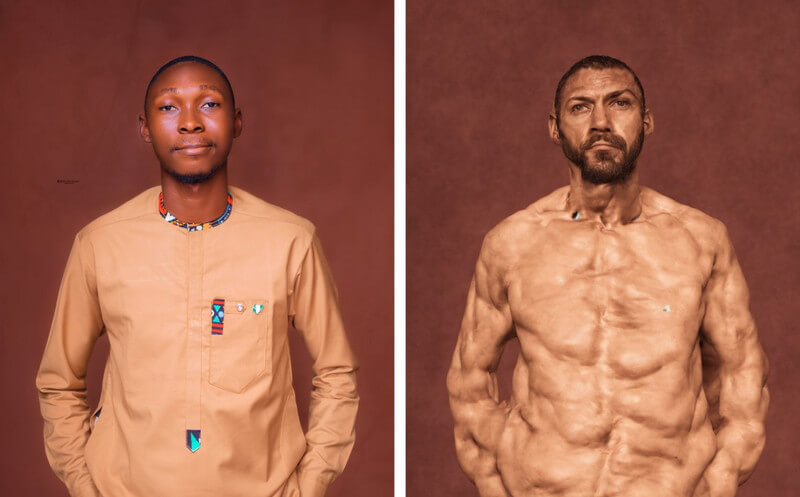

Le modèle d'IA prend l'image comme image source et crée des images ultérieures à l'aide d'une technique unique, connue sous le nom de diffusion. Idéalement, la technique ajoute divers détails (que ce soit pour l'arrière-plan ou l'objet) à une image source, ce qui en fait une vidéo. Stability AI a formé le modèle sur la base d'un large ensemble de vidéos et de photos réalistes, qui peuvent s'exécuter virtuellement ou sur un système local.

Dans l'ensemble, Diffusion vidéo stable est un outil puissant qui peut vous aider à créer toutes sortes de vidéos, du contenu créatif au contenu éducatif. Bien qu'il ait été récemment publié, le modèle est encore en développement et devrait évoluer à l'avenir.

Actuellement, vous pouvez utiliser la fonctionnalité vidéo de Stable Diffusion de deux manières : vous pouvez soit l'installer sur votre système, soit utiliser n'importe quelle application Web.

Depuis Vidéo AI à diffusion stable en vidéo gratuite La solution est une offre open source, divers outils tiers l'ont intégrée sur leurs plateformes. Par exemple, vous pouvez visiter le site Web : https://stable-video-diffusion.com/ et téléchargez votre photo. Une fois la photo téléchargée, l'outil l'analysera automatiquement et la convertira en vidéo.

C'est ça! En quelques secondes, l'outil en ligne générera une courte vidéo basée sur la photo téléchargée. Vous pouvez simplement prévisualiser la vidéo ici et la télécharger sur votre système.

Si vous souhaitez obtenir des résultats plus personnalisés (et non filtrés), vous pouvez également envisager d'installer le module AI à partir de Vidéo stable La diffusion sur votre système. Cependant, sachez que le processus est un peu technique et consommera des ressources informatiques importantes.

Conditions préalables:

Une fois que vous avez rempli les conditions ci-dessus, vous pouvez lancer la console Python sur votre système. Maintenant, vous pouvez exécuter les commandes suivantes une par une, qui créeront, activeront et installeront les dépendances requises sur votre système pour exécuter Stable Diffusion.

python3 -m venv venv

source venv/bin/activer

pip install -r exigences.txt

Une fois l’environnement opérationnel sur votre système, vous pouvez préparer une image d’entrée. Si vous n'avez pas d'image, vous pouvez utiliser l'IA de diffusion stable standard pour en créer une en saisissant du texte.

Pour générer la vidéo, vous pouvez simplement naviguer dans le diffusion-vidéo-stable direction sur votre système. Entrez simplement la commande suivante pour générer la vidéo, en utilisant une image d'entrée :

python3 scripts/dream.py –ckpt_path ckpt/stable-diffusion.ckpt –image_path input_image.png –prompt « texte d'invite » –fps 6 –num_frames 100 –augmentation_level 0.5

Veuillez noter que dans la commande ci-dessus, vous devez effectuer les opérations suivantes :

Après avoir entré l'invite, vous pouvez attendre un moment pendant que le Génération vidéo à diffusion stable termine son traitement. Si le processus est plus complexe, la diffusion stable peut prendre un certain temps pour générer ses résultats.

Une fois la génération vidéo terminée, elle sera enregistrée dans le sortir répertoire avec l'horodatage comme nom.

De cette façon, vous pouvez utiliser le Vidéo AI à diffusion stable en vidéo gratuite (ou photo en vidéo gratuite) pour générer des vidéos. Vous pouvez expérimenter davantage avec diverses invites et paramètres de saisie pour modifier les résultats.

En un mot, Stable Diffusion est un Modèle d'IA créé par Stability AI pour générer du contenu multimédia de haute qualité (photos et vidéos). Il s'agit d'une version plus stable de ses modèles précédents, qui génère des images réalistes et sans erreurs.

D’un autre côté, Unstable Diffusion est son homologue plus créatif et sans restriction. Contrairement à Stable Diffusion, qui a été formé sur un ensemble de données d'images filtrées, Unstable Diffusion a des images non filtrées comme ensemble de données. C'est pourquoi Unstable Diffusion peut souvent conduire à des erreurs dans ses résultats et produit un travail plus abstrait que réaliste.

Depuis Diffusion vidéo stable est encore en évolution, il est difficile de prédire son impact réel, mais il peut avoir l’influence suivante :

Comme vous le savez, Stable Diffusion peut générer des vidéos en quelques secondes, ce qui peut aider les créateurs de contenu à gagner du temps. Vous pouvez créer des animations, ajouter des effets spéciaux ou transférer instantanément des styles de vidéos au lieu de passer des heures à éditer.

Les efforts manuels que nous consacrons au montage vidéo peuvent être coûteux et prendre du temps. D'autre part, Diffusion vidéo stable peut vous aider à réduire ces coûts de montage en automatisant la plupart des tâches de post-production.

Les créateurs peuvent désormais créer des vidéos au-delà de leur créativité restreinte grâce à Stable Diffusion. Par exemple, il peut être utilisé pour générer des vidéos avec des effets spéciaux réalistes ou pour animer des images fixes.

Comme je l'ai mentionné ci-dessus, Stable Diffusion est un outil open source, accessible gratuitement à tous. Cela en fait un atout créatif précieux pour quiconque souhaite créer des vidéos, quels que soient ses compétences ou son budget.

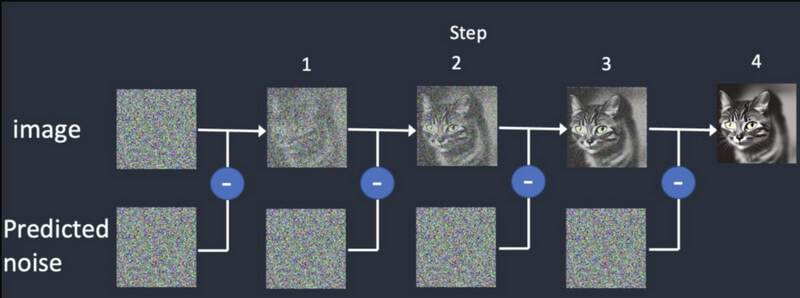

Comme son nom l’indique, le modèle d’IA repose sur une pratique de diffusion qui entraîne l’intelligence artificielle à générer des médias réalistes. Il repose sur trois grands principes :

La diffusion: En diffusion, nous commençons d'abord par une image aléatoire, puis nous y ajoutons progressivement des détails. Il continuera à fournir différentes sorties jusqu'à ce qu'il corresponde à l'entrée initiale. Cela formera le Génération vidéo à diffusion stable proposer des cadres synthétiques, basés sur celui initial.

Entraînement: Tout comme une image, le modèle de diffusion est formé sur un ensemble de données massif. De cette façon, le modèle d’IA peut facilement distinguer et générer toutes sortes d’objets réalistes.

Génération vidéo: Une fois le modèle entraîné, les utilisateurs peuvent charger une image dans le modèle IA. Le modèle affinera le bruit pour chaque image et proposera des sorties réalistes, basées sur les entrées fournies pour les couleurs, les rotations, les changements visuels, etc.

Diffusion vidéo stable est récemment publié et présente plusieurs limitations, notamment les suivantes :

La bonne nouvelle est que le modèle d'IA actuel du Diffusion vidéo stable est disponible gratuitement. Selon Stability AI, le modèle a déjà été développé à des fins de recherche. Vous pouvez accéder au code du modèle sur sa page GitHub ici : https://github.com/Stability-AI/generative-models

En plus de cela, vous pouvez accéder à sa documentation sur Hugging Face ici : https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt

Stability AI a lui-même effectué des recherches approfondies et comparé son modèle de génération vidéo avec d'autres outils. Selon la recherche, Stable Video Diffusion est comparée à des modèles comme Runway et Pika Labs.

Ici, vous pouvez voir comment ces modèles fonctionnent pour générer 14 et 25 images à une fréquence personnalisée de 3 à 30 ips. Stable Diffusion est également plus puissant que Google Video Diffusion et DALL.E lorsqu'il s'agit de générer des vidéos réalistes.

| Modèle | Force | Faiblesse |

| Diffusion vidéo stable | Résultats réalistes et cohérents, parfaits pour les courtes vidéos à partir d'images fixes | Durée limitée, variations de qualité, contrôle créatif limité |

| Diffusion de vidéos Google | Peut générer des vidéos plus longues, idéales pour la génération de texte en vidéo | Peut produire des erreurs, nécessite un réglage fin (pas si stable) |

| DALL-E2 | Très créatif et expérimental | Peut être moins stable |

| Piste ML | Facile à utiliser et bon pour les débutants | Capacités limitées et pas aussi puissantes que les autres modèles |

| Laboratoires Pika | Open source | Base d'utilisateurs limitée, toujours en développement |

Non – pour l’instant, les résultats du Génération vidéo à diffusion stable sont limités à 4 secondes maximum. Cependant, dans les prochaines versions de cette IA, on pourrait s’attendre à ce qu’elle génère également des vidéos de longue durée.

Voici quelques-unes des exigences pour exécuter Diffusion vidéo stable:

| Exigence | Le minimum | Recommandé |

| GPU | 6 Go de mémoire vidéo | 10 Go de VRAM (ou supérieur) |

| CPU | 4 cœurs | 8 cœurs (ou supérieur) |

| RAM | 16 GB | 32 Go (ou plus) |

| Stockage | 10 Go | 20 Go (ou plus) |

En plus de cela, vous devez au préalable installer Python 3.10 (ou supérieur) sur votre système.

Actuellement, Stability AI n'a publié que Diffusion vidéo stable à des fins de recherche afin que le modèle puisse évoluer. Cependant, à l’avenir, nous pourrions nous attendre à ce que le modèle d’IA évolue dans les fonctionnalités suivantes :

Je suis sûr qu'après avoir lu cet article, vous comprendrez facilement comment Génération vidéo à diffusion stable travaux. J'ai également proposé quelques étapes rapides que vous pouvez suivre pour commencer Diffusion vidéo stable tout seul. Cependant, vous devez vous rappeler que le Modèle d'IA est relativement nouveau, est encore en apprentissage et pourrait ne pas répondre exactement à vos besoins. Allez-y : essayez le modèle vidéo génératif Stability AI et continuez à l'expérimenter pour libérer votre créativité !